Kuidas teha Yandexis kiiret indekseerimist

Kuni otsingumootor saidi lehe ei indekseeri, ei osale see selle otsingutulemustes. Otsingumootor saab saidi kohta teada kahel viisil.

- veebihaldurilt. Miks peate Yandexi lisandmoodulile lisama veebidokumendi URL-i või Google(inglise keelest lisa url).

- navigeerides saidi lehtedele muude indekseeritud veebidokumentide linkide kaudu.

Selles ajaveebis puutusin kokku olukorraga, kus Yandex indekseeris probleemideta ainult avalehe, kuid sisemised otsingus ei osalenud. Google ei kogenud sarnast tähelepanematust. Seal võisite oma artiklit otsingutulemustes peaaegu koheselt märgata.

Miks ei ole saiti Yandexis indekseeritud?

- Google sisestab kõik saidi lehed oma andmebaasi: kvaliteetsed ja madala kvaliteediga, valimatult. Kuid edetabelis on kaasatud ainult kasulikud veebidokumendid [mitte segi ajada]. Yandex ei sisalda kohe veebirämpsu. Saate sundida seda suvalise lehe indekseerima, kuid aja jooksul eemaldab otsingumootor prügi. Mõlemal süsteemil on täiendav indeks. Mõlema süsteemi puhul mõjutavad madala kvaliteediga lehed saidi kui terviku asetust. Viimase punkti kohta on ametlik avaldus [vt. Google'i ajaveeb] ja lihtne loogika. Konkreetse inimese lemmiksaidid on tema otsingutulemustes kõrgematel kohtadel. Kuid samal inimesel on raskusi saidi leidmisega, mis teda eelmisel korral ei huvitanud. Seetõttu peate esmalt blokeerima dubleerivate veebidokumentide indekseerimise, kontrollima, kas puuduvad sisuga leheküljed ja mitte lubama väärtusetut sisu otsingutulemustesse.

- Webmaster.Yandexi „Kontrolli URL-i” tuletab teile meelde, mida või mida server edastab.

- Kui ostsite toetatud domeeni, mille suhtes kohaldati sanktsioone, peate tugiteenusele kirjutama näiteks Tere. 1. jaanuaril 2000 omandati domeen site.ru. 20. jaanuaril 2000 lisati sait Webmasterisse ja Addurilka. Kolme nädala pärast seda ei indekseeritud. Palun öelge, kas domeen võib põhjustada kehva indekseerimise?

Kuidas kiirendada indekseerimist Yandexis

- Kinnitage saidi haldamise õigused saidil Yandex.Webmaster.

- Avalda link artiklile . Alates 2012. aastast on Yandex temaga lepingu sõlminud.

- Installige oma arvutisse Yandexi brauser ja navigeerige selle abil saidi lehtedel.

- Lisama . Seal saate veerus "Indekseerimine" oma URL-id käsitsi sisestada, täpselt nagu Addurilis. [pole asjakohane]

- Installige Yandex.Metrica kood, märkimata märkeruutu "Lehtede indekseerimiseks saatmise keeld".

- Looge saidiplaani fail. Seejärel kontrollib robot seda objektile saabudes esmalt. See fail on ainult tema jaoks ja pole publikule nähtav. See koosneb lehe URL-ide loendist. Äsja loodud või värskendatud sisuga on ülaosas. Saidiplaani aadress registreeritakse failis robots.txt või vastaval kujul veebihalduris - "Indekseerimisseaded" - "Saidiplaani failid".

Lisatoimingud, kui Yandex on indekseerinud ainult 1 lehe

- Mida sagedamini lehte uuendatakse, seda sagedamini otsingurobot seda uuesti indekseerib. Põhimõtteliselt muutub sisu perioodiliselt "saidikaardil" ja avalehel. Mida sagedamini uusi artikleid avaldatakse, seda sagedamini eelnimetatud lehekülgi uuendatakse ja uut materjali indekseeritakse nende sees olevate linkide kaudu.

- Kui teete läbiva ploki kõikidele viimaste kirjalike väljaannetega lehtedele, saab otsingurobot minna uuele postitusele igalt külastatud saidi lehelt. Ja see on kiirem. Otsast lõpuni ploki linke ei tohiks rakendada skripti abil; neid pole vaja.

- Saidid, millel on , saavad registreeruda kataloogis Yandex.blogs ja sealt edastatakse andmed põhirobotisse.

- Jätke lingid oma artiklitele sageli uuendatavates ressurssides: "LiveJournal", ", "" jne.

Andmebaasi värskendus - probleemi värskendus(ed)- esineb keskmiselt kord nädalas. Kui kõik ülaltoodud toimingud ei aidanud, mida mul pole kunagi olnud, peaksite kirjutama tugiteenusele kirja, rääkides neile, mis tehti, natuke saidi kohta, et seda värskendatakse regulaarselt, et inimesed on sellest huvitatud. , tooge näidetena paar linki parimatele artiklitele. Kui ressursil on kitsa teema tõttu väike liiklus, peate sellest rääkima. Näiteks öelge, et projekt ei plaani suurt osavõttu, kuna see on loodud lepidopteroloogide seltsile, kes uurib liblikate sugukonda kuuluvaid liblikaid. Kui sait on äriline, siis märkige, et selle taga on tõeline organisatsioon.

Oleme välja andnud uue raamatu „Sotsiaalmeedia sisuturundus: kuidas saada oma jälgijate pähe ja panna nad oma kaubamärgisse armuma”.

Saidi indekseerimine on saidi teabe otsimise, kogumise, töötlemise ja otsingumootori andmebaasi lisamise protsess.

Rohkem videoid meie kanalil – õppige SEMANTICA abil internetiturundust

![]()

Saidi indekseerimine tähendab, et otsingumootori robot külastab ressurssi ja selle lehti, uurib sisu ja sisestab selle andmebaasi, seejärel tagastatakse see teave võtmepäringute alusel. See tähendab, et võrgu kasutajad sisestavad päringu otsinguribale ja saavad vastuse indekseeritud lehtede loendi kujul.

Lihtsamalt öeldes kõlab see umbes nii: kogu Internet on tohutu raamatukogu. Igal endast lugupidaval raamatukogul on kataloog, mis hõlbustab vajaliku teabe leidmist. Eelmise sajandi 90ndate keskel taandus kogu indekseerimine sellisele kataloogimisele. leidis veebisaitidelt märksõnu ja moodustas nendest andmebaasi.

Tänapäeval koguvad ja analüüsivad robotid infot mitme parameetri (vead, unikaalsus, kasulikkus, saadavus jne) alusel enne selle otsingumootorisse sisestamist.

Otsingurobotite algoritme uuendatakse pidevalt ja need muutuvad keerukamaks. Andmebaasid sisaldavad tohutul hulgal teavet, hoolimata sellest ei võta vajaliku teabe otsimine palju aega. See on näide kvaliteetsest indekseerimisest.

Kui sait pole indekseeritud, ei pruugi teave kasutajateni jõuda.

Kuidas Google'i ja Yandexi saite indekseerida

Yandex ja Google on võib-olla Venemaal kõige populaarsemad otsingumootorid. Selleks, et otsingumootorid saaksid teie saiti indekseerida, peate sellest teatama. Seda saate teha kahel viisil.

- Lisage sait indekseerimiseks, kasutades linke muudel Interneti-ressurssidel - seda meetodit peetakse optimaalseks, kuna robot peab sel viisil leitud lehti kasulikuks ja indekseeritakse kiiremini, 12 tunnist kahe nädalani.

- Esitage oma sait indekseerimiseks, täites käsitsi spetsiaalse otsingumootori vormi, kasutades teenuseid Yandex.Webmaster, Google Webmaster Tools, Bing Webmaster Tools jne.

Teine meetod on aeglasem; sait pannakse järjekorda ja indekseeritakse kaks nädalat või kauem.

Uued saidid ja lehed indekseeritakse keskmiselt 1–2 nädalaga.

Arvatakse, et Google indekseerib saite kiiremini. See juhtub seetõttu, et Google'i otsingumootor indekseerib kõik lehed – nii kasulikud kui ka mittekasulikud. Kuid järjestatakse ainult kvaliteetne sisu.

Yandex töötab aeglasemalt, kuid indekseerib kasulikud materjalid ja jätab kohe otsingust välja kõik rämpslehed.

Saidi indekseerimine toimib järgmiselt:

- otsingurobot leiab portaali ja uurib selle sisu;

- saadud teave sisestatakse andmebaasi;

- umbes kahe nädala pärast ilmub päringu korral otsingutulemustesse materjal, mis on edukalt läbinud indekseerimise.

Saidi ja selle lehtede indekseerimise kontrollimiseks Google'is ja Yandexis on kolm võimalust:

- veebihaldurite tööriistade kasutamine – google.com/webmasters või webmaster.yandex.ru;

- sisestades otsinguribale spetsiaalsed käsud, näeb Yandexi käsk välja järgmine: host: saidi nimi + esimese taseme domeen; ja Google - sait: saidi nimi + domeen;

- kasutades spetsiaalseid automaatteenuseid.

Indekseerimise kontrollimine

Seda saab teha kasutades:

- otsingumootorite operaatorid – vaata abist või ;

- eriteenused, näiteks rds baar;

Kuidas kiirendada saidi indekseerimist

Uue materjali otsingutulemustesse ilmumise kiirus sõltub sellest, kui kiiresti robotid indekseerimist teostavad ja seda kiiremini sihtrühm lehele jõuab.

Otsingumootorite indekseerimise kiirendamiseks peate järgima mitmeid soovitusi.

- Lisage sait otsingumootorisse.

- Täitke projekt regulaarselt ainulaadse ja kasuliku sisuga.

- Saidil navigeerimine peaks olema mugav, ligipääs lehtedele ei tohiks olla avalehelt pikem kui 3 klõpsu.

- Asetage ressurss kiirele ja usaldusväärsele hostimisele.

- Konfigureerige fail robots.txt õigesti: kõrvaldage mittevajalikud piirangud, blokeerige teenuselehtede indekseerimine.

- Kontrollige vigu, märksõnade arvu.

- Loo sisemine linkimine (lingid teistele lehtedele).

- Postitage artiklite lingid sotsiaalvõrgustikesse ja sotsiaalsetesse järjehoidjatesse.

- Looge saidikaart või isegi kaks, üks külastajatele ja teine robotitele.

Kuidas blokeerida saidi indekseerimine

Blokeeri saidi indekseerimine – keelake otsingurobotite juurdepääs saidile, mõnele selle lehele, osale tekstist või pildist. Tavaliselt tehakse seda tundliku teabe, tehniliste lehtede, arendustaseme saitide, dubleerivate lehtede jms avaliku juurdepääsu eest varjamiseks.

Seda saate teha mitmel viisil.

- Fati robots.txt abil saate takistada saidi või lehe indekseerimist. Selleks luuakse veebilehe juurtes tekstidokument, mis paneb paika otsingumootori robotite reeglid. Need reeglid koosnevad kahest osast: esimene osa (User-agent) näitab adressaati ja teine (Disallow) keelab mis tahes objekti indekseerimise.

Näiteks kogu saidi indekseerimise keelamine kõigile otsingurobotidele näeb välja järgmine:

Kasutaja agent: *

Keela: /

- Kasutades robotite metasilti, mida peetakse kõige õigemaks viisiks ühe lehe indekseerimise blokeerimiseks. Märgendite noindex ja nofollow abil saate takistada otsingumootorite robotitel saiti, lehte või tekstiosa indekseerimist.

Kirje terve dokumendi indekseerimise keelamiseks näeb välja järgmine:

Saate luua konkreetse roboti jaoks keelu:

Mida mõjutab indekseerimine edutamise ajal?

Tänu indekseerimisele kaasatakse saidid otsingumootorisse. Mida sagedamini sisu värskendatakse, seda kiiremini see juhtub, kuna robotid tulevad saidile sagedamini. Selle tulemuseks on kõrgem otsingujärjestus.

Saidi indekseerimine otsingumootorites annab külastajate sissevoolu ja aitab kaasa projekti arendamisele.

Lisaks sisule hindavad robotid liiklust ja külastajate käitumist. Nende tegurite põhjal teevad nad järeldusi ressursi kasulikkuse kohta, külastavad saiti sagedamini, mis tõstab selle otsingutulemustes kõrgemale positsioonile. Järelikult liiklus taas suureneb.

Indekseerimine on projektide edendamisel oluline protsess. Et indekseerimine oleks edukas, peavad otsingurobotid tagama teabe kasulikkuse.

Otsingumootorite kasutatavad algoritmid muutuvad pidevalt ja muutuvad keerukamaks. Indekseerimise eesmärk on info sisestamine otsingumootori andmebaasi.

Mis on indekseerimine? See on protsess, mille käigus robot võtab teie saidi lehtede sisu vastu ja lisab selle sisu otsingutulemustesse. Kui vaatame numbreid, siis indekseerimisroboti andmebaas sisaldab triljoneid veebisaidi lehtede aadresse. Iga päev küsib robot miljardeid selliseid aadresse.

Kuid kogu selle Interneti indekseerimise suure protsessi saab jagada väikesteks etappideks:

Esiteks peab indekseerimisrobot teadma, et teie saidil on ilmunud leht. Näiteks indekseerides teisi Interneti-lehti, otsides linke või laadides alla komplekti nemp. Saime lehe kohta teada, pärast mida kavatseme sellel lehel roomata, saata andmed teie serverisse, et seda saidi lehte taotleda, saada sisu vastu ja lisada see otsingutulemustesse.

Kogu see protsess on indekseerimisroboti vahetamine teie veebisaidiga. Kui indekseerimisroboti saadetud päringud praktiliselt ei muutu ja muutub ainult lehe aadress, siis sõltub teie serveri vastus roboti lehepäringule paljudest teguritest:

- oma CMS-i seadetest;

- hostingu pakkuja seadetest;

- vahepakkuja tööst.

See vastus on lihtsalt muutumas. Esiteks saab teie saidi robot lehe taotlemisel järgmise teenusevastuse:

Need on HTTP-päised. Need sisaldavad erinevat teenindusteavet, mis võimaldab robotil mõista, millist sisu nüüd edastatakse.

Tahaksin keskenduda esimesele päisele – see on HTTP vastuse kood, mis näitab indekseerivale robotile selle lehe olekut, mida robot taotles.

Selliseid HTTP-koodi olekuid on mitukümmend:

Ma räägin teile kõige populaarsematest. Kõige tavalisem vastusekood on HTTP-200. Leht on saadaval, seda saab indekseerida, lisada otsingutulemustesse, kõik on korras.

Selle oleku vastand on HTTP-404. Leht pole saidil, seal pole midagi indekseerida ega midagi otsingusse kaasata. Saitide struktuuri muutmisel ja siselehtede aadresside muutmisel soovitame seadistada ümbersuunamiseks 301-serveri. See lihtsalt annab robotile märku, et vana leht on kolinud uuele aadressile ja otsingutulemustesse on vaja lisada uus aadress.

Kui lehe sisu ei ole muutunud pärast viimast korda, kui robot lehte külastas, on kõige parem tagastada HTTP-304 kood. Robot saab aru, et otsingutulemustes pole lehekülgi vaja uuendada ja sisu ka üle ei kanta.

Kui teie sait on saadaval vaid lühikest aega, näiteks serveris tööd tehes, on kõige parem konfigureerida HTTP-503. See annab robotile märku, et sait ja server pole praegu saadaval, peate veidi hiljem tagasi tulema. Lühiajalise kättesaamatuse korral takistab see lehtede otsingutulemustest väljajätmist.

Lisaks nendele HTTP-koodidele ja lehe olekutele peate otse hankima ka lehe enda sisu. Kui tavakülastaja jaoks näeb leht välja selline:

need on pildid, tekst, navigeerimine, kõik on väga ilus, siis indekseerimisroboti jaoks on mis tahes leht lihtsalt lähtekoodi komplekt, HTML-kood:

Erinevad metasildid, tekstisisu, lingid, skriptid, palju igasugust infot. Robot kogub selle kokku ja lisab selle otsingutulemustesse. Tundub, et kõik on lihtne: nad taotlesid lehte, said oleku, said sisu ja lisasid selle otsingusse.

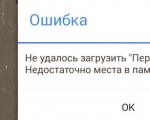

Kuid mitte ilmaasjata saab Yandexi otsinguteenus veebihalduritelt ja saidiomanikelt rohkem kui 500 kirja, mis kinnitavad, et serveri vastusega on tekkinud teatud probleemid.

Kõik need probleemid võib jagada kaheks osaks:

Need on probleemid HTTP vastuse koodiga ja probleemid HTML-koodiga, lehtede otsese sisuga. Nendel probleemidel võib olla palju põhjuseid. Kõige tavalisem on see, et hostingu pakkuja blokeerib indekseerimisroboti.

Näiteks avasite veebisaidi ja lisasite uue jaotise. Robot hakkab teie saiti sagedamini külastama, suurendades serveri koormust. Majutusteenuse pakkuja näeb seda oma jälgimisel, blokeerib indekseerimisroboti ja seetõttu ei pääse robot teie saidile juurde. Lähete oma ressursi juurde - kõik on korras, kõik töötab, lehed on ilusad, kõik avaneb, kõik on suurepärane, kuid robot ei saa saiti indekseerida. Kui sait pole ajutiselt saadaval, näiteks kui unustasite domeeninime eest maksta, on sait mitmeks päevaks keelatud. Robot tuleb saidile, see on ligipääsmatu, sellistel tingimustel võib see mõne aja pärast sõna otseses mõttes otsingutulemustest kaduda.

Valed CMS-i sätted, näiteks värskendamisel või teisele CMS-ile üleminekul, kujunduse värskendamisel, võivad samuti põhjustada teie saidi lehtede kadumist otsingutulemustest, kui seaded on valed. Näiteks keelava metasildi olemasolu saidi lehtede lähtekoodis, kanoonilise atribuudi vale seadistus. Veenduge, et pärast kõiki saidil tehtud muudatusi on leheküljed robotile juurdepääsetavad.

Yandexi tööriist aitab teid selles. Veebihaldurile serveri vastuse kontrollimiseks:

Näete, millised HTTP-päised teie server robotile tagastab, ja lehtede sisu.

Jaotises "Indekseerimine" on statistika, kus saate vaadata, millised lehed on välistatud, nende näitajate muutuste dünaamikat ning teha erinevaid sortimis- ja filtreerimisvõimalusi.

Samuti rääkisin juba täna sellest jaotisest, jaotisest "saidi diagnostika". Kui teie sait muutub robotile kättesaamatuks, saate vastava teate ja soovitused. Kuidas seda parandada? Kui selliseid probleeme ei teki, sait on ligipääsetav, vastab 200 koodile ja sisaldab õiget sisu, siis hakkab robot automaatselt külastama kõiki tuvastatud lehti. See ei too alati kaasa soovitud tagajärgi, mistõttu saab roboti tegevust teatud viisil piirata. Selle jaoks on fail robots.txt. Sellest räägime järgmises osas.

Robots.txt

Fail robots.txt ise on väike tekstidokument, see asub saidi juurkaustas ja sisaldab indekseerimisroboti jaoks rangeid reegleid, mida tuleb saidil roomamisel järgida. Faili robots.txt eelisteks on see, et selle kasutamiseks pole vaja eriteadmisi ega eriteadmisi.

Kõik, mida pead tegema, on avada Notepad, sisestada teatud vormingureeglid ja seejärel lihtsalt fail serverisse salvestada. Ühe päeva jooksul hakkab robot neid reegleid kasutama.

Kui võtame näite lihtsast failist robots.txt, siis see on järgmisel slaidil:

Direktiiv „User-Agent:” näitab, millistele robotitele reegel on mõeldud, lubades/keeldudes käskkirju ning abisaidiplaani ja hosti käskkirju. Natuke teooriat, tahaksin liikuda edasi praktika juurde.

Paar kuud tagasi tahtsin osta sammulugejat, mistõttu pöördusin Yandexi poole. Turu, et saada abi valiku tegemisel. Kolis Yandexi avalehelt Yandexi. Turg ja jõudis teenuse avalehele.

Allpool näete selle lehe aadressi, kuhu ma läksin. Teenuse enda aadress lisas ka minu kui saidi kasutaja identifikaatori.

Seejärel läksin jaotisse "kataloog".

Valisin soovitud alajaotuse ja seadistasin sorteerimisparameetrid, hinna, filtri, sortimise viisi ja tootja.

Sain toodete nimekirja ja lehe aadress on juba kasvanud.

Läksin soovitud toote juurde, vajutasin nuppu “Lisa ostukorvi” ja jätkasin maksmist.

Minu lühikese teekonna jooksul muutusid lehtede aadressid teatud viisil.

Neile lisati teenuse parameetrid, mis tuvastasid mind kasutajana, seadistasid sortimise ja näitasid saidi omanikule, kust ma saidi sellele või teisele lehele tulin.

Ma arvan, et sellised lehed, teeninduslehed, ei paku otsingumootori kasutajatele kuigi huvi. Kuid kui need on indekseerivale robotile kättesaadavad, võidakse need otsingusse kaasata, kuna robot käitub sisuliselt nagu kasutaja.

Ta läheb ühele lehele, näeb linki, millel saab klõpsata, läheb sellele, laadib andmed oma roboti andmebaasi ja jätkab kogu saidi roomamist. See selliste aadresside kategooria hõlmab ka kasutajate isikuandmeid, näiteks tarneteavet või kasutajate kontaktandmeid.

Loomulikult on parem need ära keelata. Just selles aitab fail robots.txt. Võite minna täna õhtul veebihalduri lõpus oma veebisaidile, klõpsata ja vaadata, millised lehed on tegelikult saadaval.

Faili robots.txt kontrollimiseks on Webmasteris spetsiaalne tööriist:

Saate alla laadida, sisestada lehtede aadresse, vaadata, kas need on robotile kättesaadavad või mitte.

Tehke mõned muudatused, vaadake, kuidas robot nendele muudatustele reageerib.

Vead failiga robots.txt töötamisel

Lisaks sellisele positiivsele mõjule – teenuselehtede sulgemisele võib robots.txt valesti käitlemise korral teha julma nalja.

Esiteks on kõige levinum probleem faili robots.txt kasutamisel tõeliselt vajalike saidilehtede sulgemine, need, mis peaksid olema otsingus ja päringute jaoks kuvatavad. Enne failis robots.txt muudatuste tegemist kontrollige kindlasti, kas leht, mida soovite sulgeda, kuvatakse otsingupäringute korral. Võib-olla on mõne parameetriga leht otsingutulemustes ja külastajad tulevad sellele otsingust. Seetõttu kontrollige kindlasti enne faili robots.txt kasutamist ja muutmist.

Teiseks, kui teie sait kasutab kirillitsa aadresse, ei saa te neid failis robots.txt otse näidata, need peavad olema kodeeritud. Kuna robots.txt on rahvusvaheline standard, mida kõik indekseerivad robotid järgivad, tuleb need kindlasti kodeerida. Kirillitsa tähestikku ei ole võimalik selgesõnaliselt määrata.

Kolmas populaarseim probleem on erinevad reeglid erinevate otsingumootorite erinevate robotite jaoks. Ühe indekseerimisroboti jaoks suleti kõik indekseerimislehed, teisel ei suletud midagi. Selle tulemusena on ühes otsingumootoris kõik hästi, otsitav leht on otsingus, kuid teises otsingumootoris võib olla prügikast, erinevaid prügilehti ja midagi muud. Veenduge kindlasti, et kui määrate keelu, tuleb seda teha kõigi indekseerivate robotite puhul.

Neljas populaarseim probleem on roomamisviivituse direktiivi kasutamine, kui see pole vajalik. See direktiiv võimaldab teil mõjutada indekseerimisroboti päringute puhtust. See on praktiline näide, väike veebisait, asetasin selle väikesele hostimisele, kõik on korras. Lisasime suure kataloogi, robot tuli, nägi hunnikut uusi lehti, hakkas saidile sagedamini ligi, suurendasime koormust, laadisime selle alla ja sait muutus kättesaamatuks. Seadsime Crawl-delay direktiivi, robot näeb seda, vähendab koormust, kõik on korras, sait töötab, kõik on ideaalselt indekseeritud, see on otsingutulemustes. Mõne aja pärast kasvab sait veelgi, see viiakse üle uude hostimisse, mis on valmis nende taotlustega toime tulema, suure hulga päringute korral ja nad unustavad indekseerimise viivituse direktiivi eemaldada. Selle tulemusena saab robot aru, et teie saidile on ilmunud palju lehti, kuid ei saa neid indekseerida lihtsalt kehtestatud direktiivi tõttu. Kui olete kunagi kasutanud roomamisviivituse käskkirja, veenduge, et see pole praegu olemas ja et teie teenus on valmis indekseerimisroboti koormust käsitlema.

Lisaks kirjeldatud funktsionaalsusele võimaldab robots.txt fail lahendada kaks väga olulist ülesannet – vabaneda saidil duplikaatidest ja näidata peapeegli aadress. Täpselt sellest räägime järgmises osas.

Kahekordne

Duplikaatide all peame silmas sama saidi mitut lehekülge, mis sisaldavad absoluutselt identset sisu. Kõige tavalisem näide on leheküljed, mille aadressi lõpus on kaldkriips ja ilma selleta. Samuti võib duplikaadi all mõelda sama toodet erinevates kategooriates.

Näiteks rulluisud võivad olla tüdrukutele, poistele võib sama mudel olla korraga kahes osas. Ja kolmandaks, need on ebaolulise parameetriga lehed. Nagu Yandexi näites. Turg määratleb selle lehe "seansi ID-na"; see parameeter lehe sisu põhimõtteliselt ei muuda.

Duplikaatide tuvastamiseks ja selle vaatamiseks, millistele lehtedele robot juurde pääseb, saate kasutada Yandexi. Veebihaldur.

Lisaks statistikale on seal ka nende lehtede aadressid, mille robot alla laadis. Näete koodi ja viimast kõnet.

Probleemid, milleni duplikaadid viivad

Mis on paarismängus nii halba?

Esiteks hakkab robot juurde pääsema saidi absoluutselt identsetele lehtedele, mis ei tekita lisakoormust mitte ainult teie serverile, vaid mõjutab ka kogu saidi roomamist. Robot hakkab tähelepanu pöörama dubleerivatele lehtedele, mitte nendele lehtedele, mida tuleb indekseerida ja otsingutulemustesse lisada.

Teine probleem seisneb selles, et topeltlehed, kui need on robotile ligipääsetavad, võivad sattuda otsingutulemustesse ja konkureerida põhilehtedega päringute pärast, mis loomulikult võib teatud päringute puhul leitavat saiti negatiivselt mõjutada.

Kuidas saate duplikaatidega toime tulla?

Kõigepealt soovitan kasutada "kanoonilist" silti et suunata robot põhilehele, mis tuleks indekseerida ja otsingupäringutest leida.

Teisel juhul saate kasutada 301 serveri ümbersuunamist, näiteks olukordades, kus aadressi lõpus on kaldkriips ja ilma kaldkriipsuta. Seadistame ümbersuunamise - duplikaate pole.

Ja kolmandaks, nagu ma juba ütlesin, on see fail robots.txt. Ebaolulistest parameetritest vabanemiseks saate kasutada nii keelamiskäske kui ka käsku Clean-param.

Saidi peeglid

Teine ülesanne, mida robots.txt võimaldab lahendada, on suunata robot põhipeegli aadressile.

Peeglid on saitide rühm, mis on täiesti identsed, nagu duplikaadid, ainult kaks saiti on erinevad. Tavaliselt puutuvad veebihaldurid peeglitega kokku kahel juhul – kui nad soovivad kolida uude domeeni või kui kasutaja peab tegema kättesaadavaks mitu veebisaidi aadressi.

Näiteks teate, et kui kasutajad sisestavad aadressiribale teie aadressi või teie veebisaidi aadressi, teevad nad sageli sama vea – kirjutavad valesti, panevad vale tähemärgi või midagi muud. Saate osta täiendava domeeni, et näidata kasutajatele mitte hostiteenuse pakkuja tünni, vaid saiti, kuhu nad tõesti tahtsid minna.

Keskendume esimesele punktile, sest just sellega tekivad peeglitega töötamisel kõige sagedamini probleemid.

Soovitan teil kogu kolimisprotsess läbi viia vastavalt järgmistele juhistele. Väike juhis, mis võimaldab vältida erinevaid probleeme uuele domeeninimele üleminekul:

Esiteks peate tegema saidid indekseerimisrobotile juurdepääsetavaks ja asetama neile täiesti identse sisu. Samuti veenduge, et robot teaks saitide olemasolust. Lihtsaim viis on lisada need Yandexi. Veebihaldur ja kinnitage nende õigused.

Teiseks, kasutades Host direktiivi, suunake robot peamise peegli aadressile – sellele, mis peaks olema indekseeritud ja olema otsingutulemustes.

Ootame kõikide näitajate liimimist ja ülekandmist vanast objektist uuele.

Pärast seda saate seadistada ümbersuunamise vanalt aadressilt uuele. Lihtne juhis, kui liigute, kasutage seda kindlasti. Loodan, et sellega probleeme ei teki

liigub.

Kuid loomulikult tekivad peeglitega töötamisel vead.

Esiteks on kõige olulisem probleem see, et indekseeriva roboti jaoks puuduvad selged juhised peapeegli aadressile, mis peaks olema otsingus. Kontrollige oma saitidel, et nende failis robots.txt oleks hostdirektiiv ja et see osutaks täpselt sellele aadressile, mida soovite otsingus näha.

Teine populaarseim probleem on ümbersuunamise kasutamine peamise peegli muutmiseks olemasolevas peeglirühmas. Mis toimub? Vana aadressi, kuna see suunab ümber, robot ei indekseeri ja see jäetakse otsingutulemustest välja. Sel juhul uut saiti otsingusse ei kuvata, kuna see pole peamine peegel. Kaotate liiklust, kaotate külastajaid, ma arvan, et seda pole kellelegi vaja.

Ja kolmas probleem on ühe peegli ligipääsmatus liikumisel. Kõige tavalisem näide selles olukorras on see, kui nad kopeerisid saidi sisu uuele aadressile, kuid vana aadress lihtsalt keelati, nad ei maksnud domeeninime eest ja see muutus kättesaamatuks. Loomulikult selliseid saite ei liideta, need peavad olema indekseerimisrobotile ligipääsetavad.

Kasulikud lingid töös:

- Rohkem kasulikku teavet leiate Yandex.Help teenusest.

- Kõik tööriistad, millest ma rääkisin, ja veelgi enam - on olemas Yandex.Webmasteri beetaversioon.

Vastused küsimustele

„Tänan raporti eest. Kas failis robots.txt on vaja roboti CSS-failide indekseerimine keelata või mitte?

Me ei soovita neid praegu sulgeda. Jah, parem on jätta CSS ja JavaScript, sest praegu töötame selle nimel, et indekseerimisrobot hakkaks ära tundma nii teie saidil olevaid skripte kui ka stiile ning vaataks, kuidas külastajal tavalisest brauserist läheb.

"Öelge mulle, kui saidi URL-id on vana ja uue jaoks samad, kas see on normaalne?"

See on korras. Põhimõtteliselt värskendate lihtsalt kujundust, lisate sisu.

“Saidil on kategooria ja see koosneb mitmest lehest: kaldkriips, leht1, leht2, näiteks kuni 10. Kõikidel lehtedel on sama kategooria tekst ja see osutub dubleerivaks. Kas see tekst on duplikaat või tuleks see kuidagi sulgeda, uus register teisele ja järgmistele lehtedele?

Esiteks, kuna esimese lehe lehekülgede arv ja teise lehe sisu on üldiselt erinevad, ei ole need duplikaadid. Kuid peate eeldama, et teine, kolmas ja edasised lehekülgede lehekülgede lehekülgede lehekülgedel võivad otsingusse jõuda ja need ilmuvad mõne asjakohase päringu korral. Parem lehekülgedel soovitaksin kasutada kanoonilist atribuuti, heal juhul - sellel lehel, kuhu kõik tooted on kogutud, et robot ei kaasaks lehekülgede otsingusse. Inimesed kasutavad väga sageli kanoonilist lehekülge lehekülgedel. Robot tuleb teisele lehele, näeb toodet, näeb teksti, ei kaasa lehte otsingusse ja saab atribuudi tõttu aru, et see on esimene lehekülg, mis peaks otsingutulemustes sisalduma. Kasutage kanoonilist ja sulgege tekst ise, ma arvan, et seda pole vaja.

Allikas (video): Kuidas seadistada saidi indekseerimist- Aleksander Smirnov

Magomed Tšerbišev

Jaga:Saidi indekseerimine on selle optimeerimisel kõige olulisem, vajalik ja esmane detail. Lõppude lõpuks saavad otsingumootorid just indeksi olemasolu tõttu vastata kõigile kasutajate päringutele ülimalt kiiresti ja täpselt.

Mis on saidi indekseerimine?

Saidi indekseerimine on protsess, mille käigus lisatakse otsingumootori andmebaasi teave saidi sisu kohta. Just indeks on otsingumootorite andmebaas. Saidi indekseerimiseks ja otsingutulemustes ilmumiseks peab seda külastama spetsiaalne otsingubot. Robot uurib lehekülgede kaupa kogu ressurssi kindla algoritmi abil. Selle tulemusena otsitakse ja indekseeritakse linke, pilte, artikleid jne. Samal ajal on otsingutulemustes loendis kõrgemal need saidid, mille autoriteet on teistest kõrgem.

PS-i veebisaidi indekseerimiseks on kaks võimalust:

- Värskete lehtede või loodud ressursi sõltumatu tuvastamine otsinguroboti poolt - see meetod on hea, kui teistelt, juba indekseeritud saitidelt on aktiivseid linke teie saidile. Vastasel juhul võid otsingurobotit lõputult oodata;

- URL-i sisestamine saidile selleks loodud otsingumootori vormis käsitsi - see valik võimaldab uuel saidil indekseerimiseks "järjekorda saada", mis võtab üsna kaua aega. Meetod on lihtne, tasuta ja nõuab ainult ressursi avalehe aadressi sisestamist. Seda protseduuri saab teha Yandexi ja Google'i veebihalduri paneeli kaudu.

Kuidas saiti indekseerimiseks ette valmistada?

Tasub kohe märkida, et veebisaidi avaldamine arendusjärgus on äärmiselt ebasoovitav. Otsingumootorid võivad indekseerida lõpetamata lehti, mis sisaldavad valet teavet, õigekirjavigu jne. Selle tulemusena mõjutab see negatiivselt saidi asetust ja teabe edastamist sellest ressursist otsingutes.

Loetleme nüüd punktid, mida ei tohiks indekseerimiseks ressursi ettevalmistamise etapis unustada:

- Flash-failidele kehtivad indekseerimispiirangud, seega on parem sait luua HTML-i abil;

- Seda tüüpi andmeid, nagu Java Script, ei indekseeri ka otsingurobotid, seetõttu tuleks saidil navigeerimine tekstilinkidega dubleerida ja kogu oluline teave, mida tuleks indekseerida, ei ole Java Scriptis kirjutatud;

- peate eemaldama kõik katkised siselingid, et iga link viiks teie ressursi pärislehele;

- saidi struktuur peaks võimaldama hõlpsalt liikuda alumistelt lehtedelt avalehele ja tagasi;

- Parem on tarbetu ja ebaoluline teave ja plokid teisaldada lehe allossa ning ka spetsiaalsete siltidega robotite eest peita.

Kui sageli indekseerimine toimub?

Saidi indekseerimine võib olenevalt mitmest põhjusest kesta mitu tundi kuni mitu nädalat, kuni terve kuu. Indekseerimisvärskendused või otsingumootori värskendused toimuvad erinevate ajavahemike järel. Statistika kohaselt indekseerib Yandex uusi lehti ja saite keskmiselt 1–4 nädala jooksul ning Google kuni 7 päeva jooksul.

Kuid loodud ressursi nõuetekohase eelneva ettevalmistamisega saab neid tähtaegu vähendada miinimumini. Sisuliselt taanduvad kõik PS-i indekseerimisalgoritmid ja nende töö loogika sellele, et anda kasutaja päringule kõige täpsem ja asjakohane vastus. Seega, mida sagedamini kuvatakse teie ressursile kvaliteetset sisu, seda kiiremini see indekseeritakse.

Meetodid indekseerimise kiirendamiseks

Esiteks peaksite otsimootoreid teavitama, et olete loonud uue ressursi, nagu on mainitud ülaltoodud lõigus. Samuti soovitavad paljud inimesed lisada sotsiaalsete järjehoidjate süsteemidesse uue saidi, kuid ma ei tee seda. See võimaldas tõesti mitu aastat tagasi indekseerimist kiirendada, kuna otsingurobotid "külastavad" selliseid ressursse sageli, kuid minu arvates on nüüd parem panna link populaarsest suhtlusvõrgustikust. Varsti märkavad nad teie ressursi linki ja indekseerivad selle. Sarnase efekti saab saavutada juba indekseeritud ressurssidest uuele saidile viivate otselinkide abil.

Kui mitu lehte on juba indekseeritud ja sait on arenema hakanud, võite indekseerimise kiirendamiseks proovida otsingurobotit "toita". Selleks peate perioodiliselt avaldama uut sisu ligikaudu võrdsete ajavahemike järel (näiteks iga päev 1-2 artiklit). Loomulikult peab sisu olema unikaalne, kvaliteetne, pädev ja mitte võtmefraasidest üleküllastatud. Samuti soovitan luua XML-saidiplaani, millest tuleb juttu allpool, ja lisada see mõlema otsingumootori veebihalduri paneelidesse.

Robots.txt ja saidiplaani failid

Tekstifail robots txt sisaldab juhiseid otsingumootori robotite jaoks. Samal ajal võimaldab see teatud otsingumootori jaoks keelata valitud saidi lehtede indekseerimise. Kui teete seda käsitsi, on oluline, et selle faili nimi oleks kirjutatud ainult suurtähtedega ja asuks saidi juurkataloogis; enamik CMS-e genereerib selle iseseisvalt või pistikprogrammide abil.

Saidikaart või saidikaart on leht, mis sisaldab täielikku saidi struktuuri mudelit, et aidata "kadunud kasutajaid". Sel juhul saate liikuda lehelt lehele ilma saidi navigeerimist kasutamata. Selline kaart on soovitav luua otsingumootoritele XML-vormingus ja sisestada see indekseerimise parandamiseks faili robots.txt.

Nende failide kohta leiate üksikasjalikumat teavet vastavates jaotistes, järgides linke.

Kuidas saidi indekseerimist blokeerida?

Saate hallata, sealhulgas keelata saidi või üksiku lehe indekseerimise, kasutades ülalmainitud faili robots.txt. Selleks looge oma arvutis selle nimega tekstidokument, asetage see saidi juurkausta ja kirjutage faili, millise otsingumootori eest soovite saidi peita. Lisaks saate märki * kasutades saidi sisu Google'i või Yandexi robotite eest peita. See juhis failis robots.txt keelab indekseerimise kõigis otsingumootorites.

Kasutajaagent: * Keela: /

WordPressi saitide puhul saate juhtpaneeli kaudu saidi indekseerimise blokeerida. Selleks peate saidi nähtavuse seadetes märkima ruudu „Soovita otsingumootoritel saiti mitte indekseerida”. Samal ajal kuulab Yandex suure tõenäosusega teie soove, kuid mitte tingimata Google'iga, kuid mõned probleemid võivad tekkida.

Kui indekseerimisega on probleeme, tuleb kõigepealt kontrollida faili robots.txml ja sitemap.xml.

Igal otsingumootoril on suur andmebaas, kus on loetletud kõik saidid ja uued lehed. Seda baasi nimetatakse "indeksiks". Kuni robot HTML-dokumendis roomamise, analüüsimise ja registrisse lisamiseni seda otsingutulemustes ei ilmu. Sellele pääseb juurde ainult lingi kaudu.

Mida tähendab "indekseerimine"?

Keegi ei saa teile sellest paremini rääkida kui Yandexi indekseerimisspetsialist:

Indekseerimine on protsess, mille käigus otsingurobot roomab saidi lehtedel ja lisab (või ei lisa) need lehed otsingumootori registrisse. Otsingubot skannib kogu sisu, teostab tekstisisu, linkide kvaliteedi, heli- ja videofailide semantilist analüüsi. Kõige selle põhjal teeb otsingumootor järeldused ja paneb saidi pingereas.

Kui sait on registrist väljas, ei tea sellest keegi, välja arvatud need, kellele saate otselinke levitada. See tähendab, et ressurss on vaatamiseks saadaval, kuid seda pole otsingumootoris.

Miks on indeksit vaja?

Sait peab olema nähtav, et reklaamida, kasvada ja areneda. Veebiressurss, mida üheski PS-is ei kuvata, on kasutu ega too kasu ei kasutajatele ega selle omanikule.

Üldiselt on siin Yandexi veebimeistrikooli täielik video; kui vaatate seda täielikult, saate indekseerimise küsimuses praktiliselt eksperdiks:

Millest sõltub indekseerimise kiirus?

Peamised punktid, mis määravad, kui kiiresti teie sait otsingurobotite tähelepanu alla jõuab:

- Domeeni vanus (mida vanem on domeeninimi, seda soodsamad on sellele robotid).

- Hosting (PS-ile ei meeldi tasuta hostimine üldse ja nad ignoreerivad seda sageli).

- CMS, koodi puhtus ja kehtivus.

- Lehekülje värskendamise kiirus.

Mis on indekseerimise eelarve?

Igal saidil on roomamise eelarve – see tähendab lehekülgede arv, mille ületamisel seda ei saa registrisse lisada. Kui saidi KB on 1000 lehekülge, siis isegi kui teil on neid kümme tuhat, on registris ainult tuhat. Selle eelarve suurus sõltub sellest, kui autoriteetne ja kasulik on teie sait. Ja kui teil on seda laadi probleem, et lehed ei kuulu registrisse, siis peate võimalusena saidi täiustama, ükskõik kui triviaalselt see ka ei kõlaks!

Saidi indekseerimine

Uue veebilehe loomisel tuleb korrektselt täita fail robots.txt, mis ütleb otsingumootoritele, kas ressurssi saab indekseerida, milliseid lehti roomata ja milliseid mitte puudutada.

Fail luuakse txt-vormingus ja paigutatakse saidi juurkausta. Õiged robotid on omaette teema. See fail määrab peamiselt seda, mida ja kuidas robotid teie saidil analüüsivad.

Tavaliselt kulub otsingumootoritel uue saidi hindamiseks ja andmebaasi sisestamiseks paar nädalat kuni paar kuud.

Ämblikud skannivad hoolikalt kõiki lubatud HTML-dokumente, määrates uue noore ressursi jaoks sobiva teema. Seda toimingut ei tehta ühe päevaga. Iga uue roomamisega lisab PS oma andmebaasi üha rohkem HTML-dokumente. Veelgi enam, aeg-ajalt hinnatakse sisu ümber, mille tulemusena võivad lehtede positsioonid otsingutulemustes muutuda.

Indekseerimist aitavad hallata ka robotite metasilt ja osaliselt kanooniline. Struktuuri kontrollimisel ja indekseerimisega seotud probleemide lahendamisel peaksite alati otsima nende olemasolu.

Google indekseerib esmalt tipptaseme lehed. Kui uut kindla struktuuriga saiti on vaja indekseerida, on avaleht esimene indekseeritav leht. Pärast seda, ilma saidi struktuuri teadmata, indekseerib otsingumootor selle, mis on kaldkriipsule kõige lähemal. Hiljem indekseeritakse kahe kaldkriipsuga kataloogid. See tähendab, et isegi kui sisu lingid on kõrged, ei pruugita neid esmalt indekseerida. Oluline on see optimaalselt üles ehitada, et olulised jaotised ei jääks liiga paljude kaldkriipsude taha, muidu otsustab Google, et tegemist on madala tasemega lehega.

Lehekülje indekseerimine

Kui Yandex ja Google on saidiga juba tuttavaks saanud ja selle oma otsinguandmebaasi vastu võtnud, naasevad robotid ressurssi, et skannida uusi lisatud materjale. Mida sagedamini ja korrapärasemalt sisu uuendatakse, seda tähelepanelikumalt ämblikud seda jälgivad.

Nad ütlevad, et Yandexi otsingu PDS-i pingeri pistikprogramm aitab indekseerida - https://site.yandex.ru/cms-plugins/. Selleks peate esmalt oma veebisaidile installima Yandexi otsingu. Aga ma ei tundnud sellest erilist kasu.

Kui ressurss on hästi indekseeritud, on otsingus palju lihtsam kuvada üksikuid uusi lehti. Kuid sellegipoolest ei toimu analüüs kõigi samaaegselt uuendatavate html-dokumentide puhul alati ühtlaselt ja sama kiirusega. Ressursi enim külastatud ja reklaamitud kategooriad võidavad alati.

Millised teabeallikad on otsingumootoritel URL-ide kohta?

Kunagi ammu palkasin kiire roboti konkurendi kallale, kes polnud oma domeeni uuendanud, et ta otsingutulemustes madalamale langeks - see ei andnud tulemust.

Kuidas kontrollida indekseerimist

html-dokumentide nähtavuse kontrollimine toimub Google'i ja Yandexi puhul erinevalt. Kuid üldiselt pole midagi keerulist. Isegi algaja saab sellega hakkama.

Kontrollimine Yandexis

Süsteem pakub kolme peamist operaatorit, mis võimaldavad kontrollida, kui palju HTML-dokumente registris on.

Operaator "site:" näitab absoluutselt kõiki ressursi lehti, mis on juba andmebaasis.

Sisestati otsinguribale järgmiselt: sait:sait

Operaator „host:” võimaldab teil näha hostimise domeenide ja alamdomeenide indekseeritud lehti.

Sisestati otsinguribale järgmiselt: host:sait

Operaator „url:” – näitab konkreetset soovitud lehte.

Sisestati otsinguribale järgmiselt: url:site/obo-mne

Nende käskudega indekseerimise kontrollimine annab alati täpsed tulemused ja on lihtsaim viis ressursi nähtavuse analüüsimiseks.

Google'i kontroll

PS Google võimaldab teil kontrollida saidi nähtavust, kasutades ainult ühte käsku, näiteks site:site.

Kuid Google'il on üks eripära: ta töötleb käske erinevalt nii koos kui ka ilma sisestatud www-ga. Yandex ei tee sellist vahet ja annab absoluutselt samu tulemusi nii registreeritud www-ga kui ka ilma.

Operaatorite kontrollimine on kõige "vanamoodsem" meetod, kuid selleks kasutan RDS-riba brauseri pistikprogrammi.

Kinnitamine veebihalduriga

Google Webmasteri ja Yandexi veebimeistri teenustes näete ka seda, kui palju lehti on PS-i andmebaasis. Selleks tuleb end nendes süsteemides registreerida ja lisada oma veebileht neisse. Nendele pääsete juurde järgmiste linkide kaudu:

http://webmaster.yandex.ru/ - Yandexi jaoks.

https://www.google.com/webmasters/- Google'i jaoks.

Kui tekst pole veel salvestatud koopias, kuid on lehel, siis leiate selle otsinguga [see tekst] url:site.ru - see tähendab, et see on juba indekseeritud, kuid pole veel sisestatud põhiindeks

Lehtede hulgikontroll indekseerimiseks

Kui jooksete, on kõigi lehtede indekseerimise kontrollimine kolme minuti küsimus.

- Minge levitamisfaili

- Valige veerus URL kõik URL-id

- Vahekaart „Andmed” – „Eemalda duplikaadid”, see jätab loendi kõigist reklaamitud lehtedest

- Kontrollime massiliselt lehtede indekseerimist Compareri abil. Võite kasutada ka Winka brauseri pistikprogrammi – see võib töötada koos Sapast eraldatud linkide loendiga (helistage pistikprogrammi menüüsse - kontrollige linkide loendit).

Kas indekseerimist on võimalik kiirendada?

Saate mõjutada otsingurobotite abil HTML-dokumentide laadimise kiirust. Selleks peaksite järgima järgmisi soovitusi:

- Suurendage sotsiaalsete signaalide arvu, julgustades kasutajaid oma profiilidel linke jagama. Või võite säutse võtta Prospero reaalajas kontodelt (klout 50+). Kui loote oma Twitteri valge nimekirja, arvake, et olete saanud võimsa relva indekseerimise kiirendamiseks;

- Lisage sagedamini uusi materjale;

- Saate alustada Directi keerutamist oma teema kõige odavamate päringute jaoks;

- Sisestage uue lehe aadress addurilkisse kohe pärast selle avaldamist.

Kõrged käitumuslikud tegurid saidil mõjutavad positiivselt ka lehe värskendamise kiirust otsingus. Seetõttu ärge unustage sisu kvaliteeti ja kasulikkust inimestele. Saidile, mis kasutajatele väga meeldib, meeldivad kindlasti otsingurobotid.

Üldjuhul on Google'is kõik väga lihtne – veebihalduri paneelis skaneerides saad mõne minuti jooksul lehe registrisse lisada (üksuse roomamine/vaatamine Googlebotina/add to index). Samamoodi saad vajalikud leheküljed kiiresti uuesti indekseerida.

Kuulsin ka lugusid meestest, kes saatsid Yandexi posti teel URL-e, et nad kiiremini registrisse pääseksid. Minu arvates on see jama.

Kui on tõsine probleem ja kõik eelnevad näpunäited ei aidanud, jääb üle vaid liikuda raskekahurväe juurde.

- Konfigureerime Viimati muudetud päised (nii et robot kontrollib värskendusi ainult dokumente, mis on pärast viimast kõnet tegelikult muutunud);

- Eemaldame prügi otsingumootori registrist (selle prügi leiate Comparseri abil);

- Peidame roboti eest kõik mittevajalikud/rämpsdokumendid;

- Loome täiendavaid Sitemap.xml faile. Tavaliselt loevad robotid sellest failist kuni 50 000 lehekülge, kui sul on rohkem lehti, pead tegema rohkem saidikaarte;

- Serveri seadistamine.